فایل Robots.txt چیست؟ چگونه در وردپرس آن را بهینه سازی کنیم؟

در صورتی که به دنبال نرخ ایندکس بالا برای سایت خود میباشید، مطالعه این پست آموزشی به شما توصیه میشود.

برخی از سایت ها به دلیل بی توجهی به فایلهای Robot.txt علاوه بر مشکلات در حوزه سئو، امنیت سایت خود را به خطر خواهند انداخت. در این بخش صفر تا صد فایل Robot.txt را بررسی خواهیم کرد.

درود بر دنبال کنندگان سایت برترآموز، ما اومدیم با یک پست آموزشی بسیار جذاب و کاربردی در حوزه سئو. یکی از مهمترین نکاتی که سایتهای برتر گوگل مورد توجه قرار میدهند، مدیریت بهتر دسترسی خزندههای گوگل میباشد. به هر اندازه که دسترسی آن ها هدفمند تعریف شود، عملکرد بسیار بهتری ارائه خواهند داد. به همین جهت نیز در دوره آموزش سئو برترآموز توجه ویژه ای به نوشتن فایل Robot.txt و همچنین نقشه سایت خواهیم داشت. اگر سایت در این بخش عملکرد مناسبی از خود ارائه ندهد، سئو تکنیکال آن با چالش مواجه میشود و برای شما نیز جذاب نخواهد بود. قبل از بررسی پاسخ سوال « فایل Robot.txt چیست » باید به شما بگوییم که دستورات از پیش تعیین شده این بخش بسیار ساده است، تنها کافیست که زمان بگذارید و تمامی آن ها را آموزش ببینید.

فایل Robot.txt چیست؟

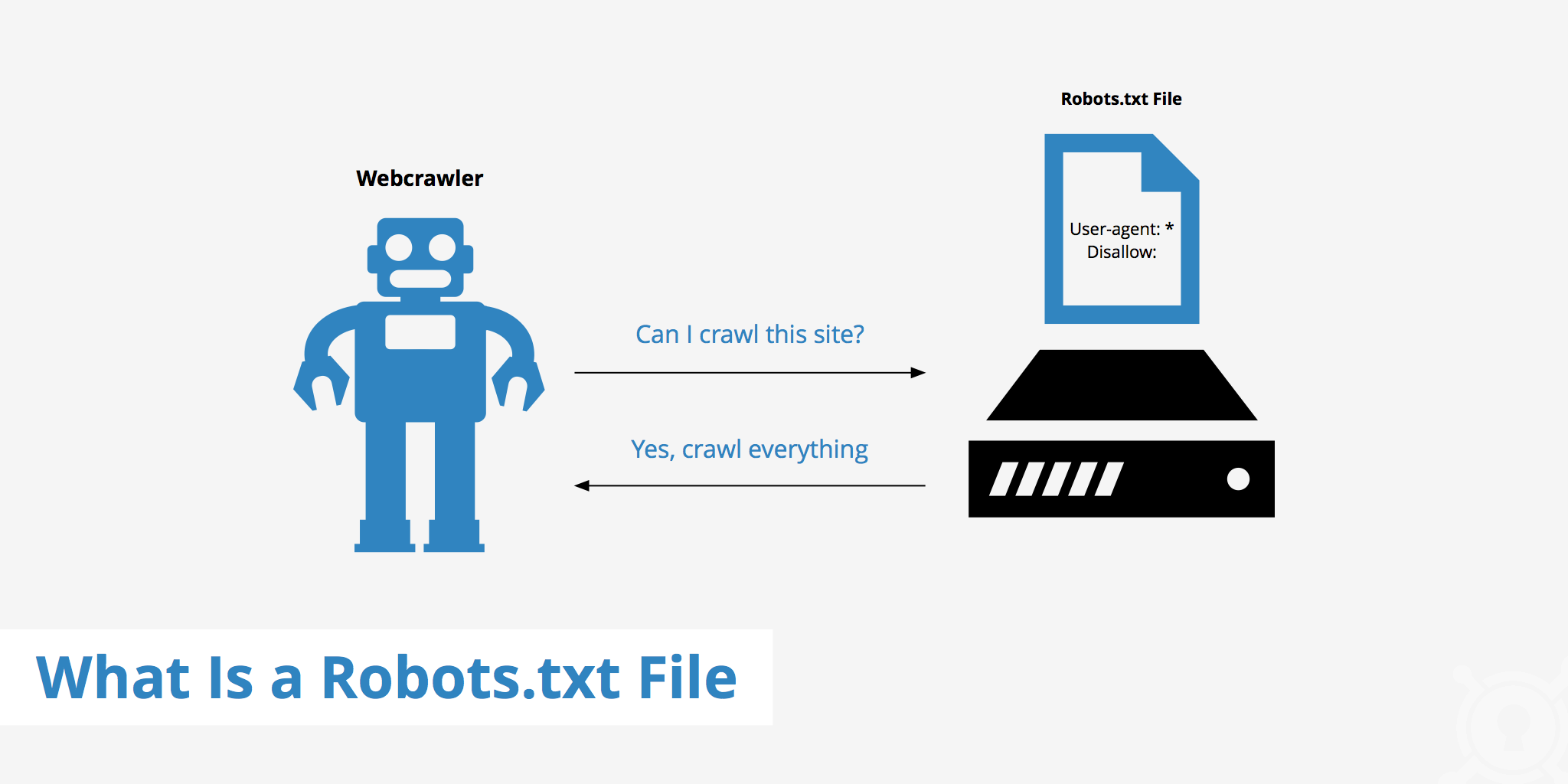

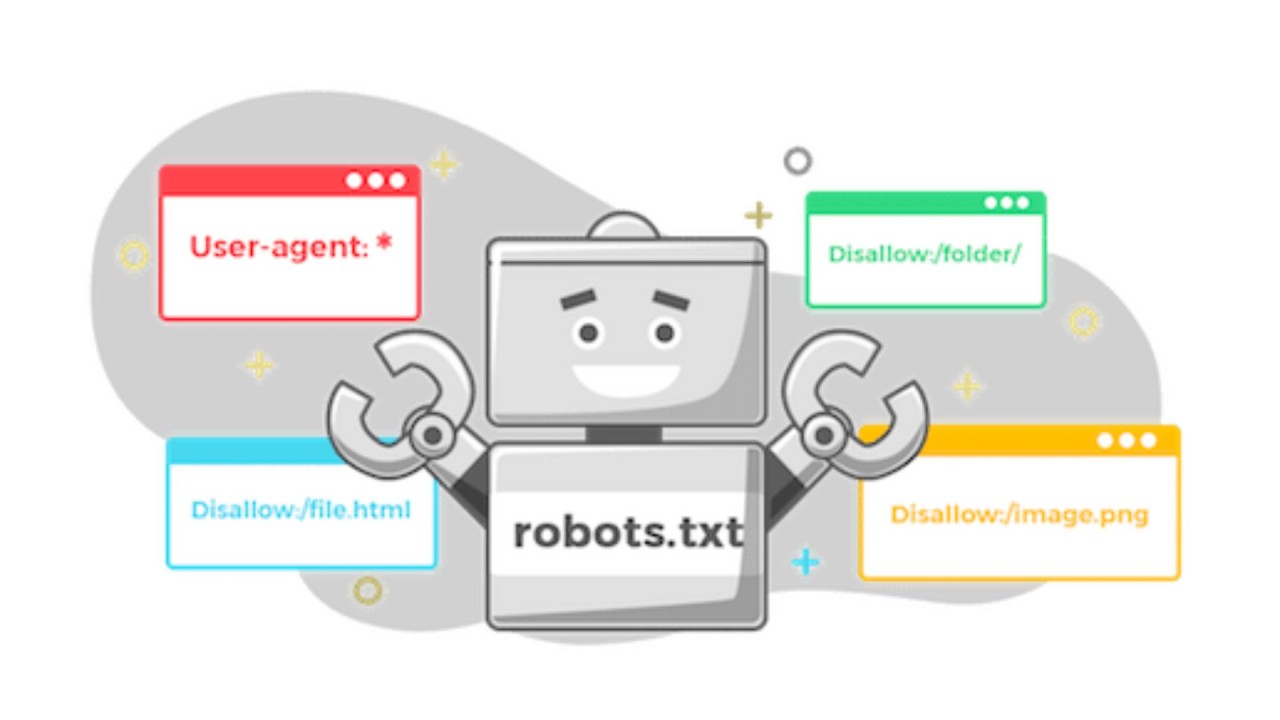

فایل Robot.txt یک دستور اجرایی از سمت مدیران سایت، به موتورهای جستجو است که با آن نرخ خزش صفحات را مدیریت میکنند. بررسی و رندرگیری موتورهای جستجو از تمامی صفحات سایت انجام میشود و اولویتی برای آن ها وجود ندارد. به همین دلیل است که ما با تعریف برخی از دستورات بررسی و خزش صفحات خود جهت دهی خواهیم کرد. به عنوان مثال خزش صفحه مدیریت سایت کار عاقلانه ای نیست و میتواند امنیت یک سایت را در خطر قرار دهد. خزش و ایندکس کردن صفحه اختصاصی پرداخت، برای کاربران اهمیت آن چنان ندارد. اما بررسی نقشه سایت برای موتورهای جستجو حائز اهمیت است. شما در فایل Robot.txt خود اول از همه اعلام حضور خواهید کرد و اولین خط را با چنین دستوری شروع میکنید.

User-agent: *

Allow: /

در ادامه دستورهای بیشتری را بررسی کردیم تا شما درک بهتری از Robot.txt به دست آورید. این دستورها معمولا به دو بخش تقسیم بندی خواهد شد. بخش اول دستورات شما لیست صفحات ممنوع را به موتورهای جستجو اعلام خواهد کرد. به عنوان مثال اگر شما یک محصول ویژه دارید که با دیگر محصولات شما حالت کنیبالیزیشن دارد و از طرفی قابل کنونیکال کردن نیست، برای جلوگیری از سئو ضعیف سایت خود، آدرس صفحه را در این بخش قرار خواهید داد. در این صورت موتورهای جستجو شما بدون هیچ مشکلی از این صفحه عبور خواهند کرد و سئو سایت شما نیز به درستی انجام خواهد شد. اگر در مورد کنیبالیزیشن اطلاعات کافی ندارید، پست آموزشی گزینه « کنیبالیزیشن یا Cannibalize در سئو چیست؟ + نحوه رفع آن » جذابی برای شما خواهد بود.

بخش دوم دستورات شما صفحات پیشنهادی به گوگل برای ایندکس کردن میباشد. البته در این بخش نقشه سایت نیز قرار داده میشود تا موتورهای جستجو بر اساس یک الگوی خاص بتوانند تصمیم گیری کنند و مورد بررسی قرار دهند. قرار دادن نقشه سایت در این بخش اهمیت بسیار بالایی دارد و به سادگی نمیتوان آن را نادیده گرفت. در ادامه انواع دستورات مدیر سایت به گوگل و موتورهای جستجو را بررسی خواهیم کرد.

چگونه یک فایل Robot.txt بسازیم و کجا قرار دهیم؟

تا این قسمت با پاسخ سوال « فایل Robot.txt چیست » به خوبی آشنا شدید. حال اگر به دنبال فایل Robot.txt میباشید، کافیست که بعد از صفحه اصلی « / Robot.txt » قرار دهید و به آن دسترسی پیدا کنید. البته برخی از سایتهای دسترسی به این بخش را محدود خواهند کرد که در یک پست آموزشی کامل و جامع در این رابطه صحبت خواهیم کرد. برای ساخت یک فایل مراحل زیر را دنبال نمایید.

- برنامه Notepad را باز کنید.

- در هر سطر یک دستور قرار دهید.

- اولین دستور خود را User-agent: * ثبت کنید.

- حال دیگر دستورات خود را به ترتیب قرار دهید. « این دستورات در ادامه بررسی خواهید شد. »

- سپس آخرین دستور خود را نقشه سایت بگذارید.

فایل شما آماده است و فرمت خروجی آن را تبدیل به UTF-8 نمایید. فایل خود را در بخش ریشه و یا همان Root سایت قرار دهید. در این صورت میتوانید محتوای خود را به صورت سازماندهی شده افزایش دهید. به یاد داشته باشید که بعد از قرار دادن فایل خود حتما از ابزار گوگل ویژه سئو تکنیکال برای چک کردن آن استفاده نمایید. چرا که وجود اختلال در سایت میتواند تمام برنامه ریزی شما را با چالش مواجه کند و از ایندکس شدن صفحات شما جلوگیری شود. البته اگر سایت خود را در سرچ کنسول ثبت کرده باشید، کار شما بسیار ساده خواهد بود.

چگونه فایل Robot.txt بهینه سازی نماییم؟

بهینه سازی فایلهای Robot.txt به چندین روش مختلف انجام خواهد شد، اما مهمترین حالت آن زمانی است که کدهای قرار داده شده به درستی ثبت شود. در صورتی که فرمت اصلی آن صحیح اجرا نشود، خزندههای گوگل درکی از فایلهای شما نخواهد داشت و همین امر موجب اختلال میشود. در نتیجه هر تغییری که بواسطه این بخش ایجاد میکنید، حتما در سرچ کنسول خود بررسی نمایید که به درستی ایفا شده باشد.

URL هر صفحه به صورت دقیق وارد شود

اگر یک صفحه حائز اهمیت میباشد و قرار است که دستور بررسی و یا عدم بررسی آن برای خزنده های گوگل ثبت شود، آدرس آن به درستی در فایل Robot.txt و همچنین نقشه سایت قرار گیرد. گاها شاهد این موضوع هستیم که یک صفحه بسیار مهم و استراتژیک گوگل در فایل Robot.txt و همچنین نقشه سایت با دو آدرس متفاوت ثبت میشود. این موضوع میتواند به رشد سایت و همچنین درک موتورهای جستجو از صفحه هدف چالش ایجاد کند.

از دستورات اصلی و ساده Allow Or Disallow استفاده کنید

سئوکاران کم تجربه فایل Robot.txt با اسکیما مارک آپ اشتباه میگیرند و از دستورات پیچیده و چند وجهی استفاده میکنند. چنین خلاقیت نابه جایی فهم موتورهای جستجو اختلال ایجاد میکند و خود باعث آسیب به نرخ خزش سایت خواهد شد. اگر سایتهای بزرگ و معتبر دنیا مانند آمازون را بررسی کنید، متوجه خواهید شد که اولویت بندی صفحات اصلی به واسطه همین دو دستور انجام شده است. حال اگر قرار است که یک صفحه را برای موتورهای جستجو برجسته نمایید، اسکیما مارکت آپ گزینه مناسبی خواهد بود. در این رابطه یک پست آموزشی بسیار جذاب و کاربردی با نام « اسکیما چیست و چه تاثیری روی سئو دارد؟ » نیز برای شما عزیزان قرار دادیم تا درک شما را نسبت به این موضوع بسیار مهم افزایش دهیم.

برای مدیریت نرخ خزش سایت خود از دستور Crowl – Delay

همانطور که میدانید نرخ خزش سایتها محدود است و با کسب جایگاه و بهینه سازی پارامترهای سئو تکنیکال نرخ ایندکس و نرخ خزش سایت خود را افزایش میدهند. استراتژیست سئو سایتهای قدیمی با تعداد صفحات زیاد برای مدیریت صفحات کم اهمیت اما کاربری سایت از دستور Crowl – Delay استفاده میکند. این کار برای موتورهای جستجو یک بازه زمانی خاص جهت خزش در این صفحات تعریف خواهد کرد. البته استفاده از چنین دستوراتی نیز به یک درک کلی از نرخ خزش و همچنین سازوکار آن دارد و نباید بی پروا از آن استفاده نمود. سایتهایی که پهنای باند کمی دارند و یا از هاست اشتراکی استفاده میکنند با کمک این دستور میتوانند نرخ خزش سایت خود را به بهترین شکل ممکن مدیریت کنند.

استفاده از دستور Wildcards برای مدیریت صفحات جلوه های پویا نمایی

در صورتی که از محتوای با کیفیت و جذاب استفاده میکنید و به دنبال اضافه کردن محتوای پویا نمایی و گیف میباشید، دستور Wildcards در برنامه ریزی خود قرار دهید. به یاد داشته باشید که فایل Robot.txt بدون توجه به پارامترهای فنی سئو تکنیکال شخصی سازی نکنید و از یک متخصص سئو تکنیکال برای استفاده از دستور Wildcards کمک بگیرید. این دستور به موتورهای جستجو کمک میکند که نرخ خزش صفحات با محتوای بصری پویا را مدیریت کنند و از طرفی درک بالاتری از محتوای آن نیز به دست آورند. بعد از اضافه کردن این دستور حتما به سرچ کنسول خود مراجعه کنید و صحت سنجی انجام دهید. این دستور در عین سادگی میتواند تاثیرات بزرگی روی نرخ خزش سایت بگذارد. در نتیجه نباید از کنار آن ساده عبور کرد.

به روز رسانی و همچنین بهینه سازی فایل Robot.txt

حال که پاسخ سوال « فایل Robot.txt چیست » از جهات مختلف فرا گرفتید، بسیار مهم است که سایت خود را به نحوی مدیریت نمایید که نرخ خزش به درستی استفاده شود. در چک لیست سئو تکنیکال نقد و بررسی فایل Robot.txt و همچنین نقشه سایت نیز قرار دارد. شما به عنوان یک سئو کار برای مدیریت بهتر این صفحه میتوانید با بهینه سازی مستمر و شخصی سازی صفحات سئو آن ها را بهتر نمایید.

محتوای تکراری در سایت خود را شناسایی و دسترسی به آن را محدود نمایید

وجود محتوای تکراری در یک سایت امری اجتناب ناپذیر است. با توجه به این موضوع مدیریت این صفحات حائز اهمیت میباشد. در زمان تهیه نقشه سایت صفحات با کانسپت تکراری را پیدا کنید و برای آن یک برنامه ریزی انجام دهید. زمانی که سایت به بلوغ محتوایی دست پیدا کرد، شما باید سعی کنید که صفحات با موضوعات مشابه را مشخص نمایید و اولویت بندی کنید. کدام یک از این صفحات قرار است که در گوگل ایندکس شود و کدام یک از این صفحات قرار است که داخل سایت به کار نمایش داده شود. بررسی این صفحات اگر به صورت سازمان یافته صورت گیرد و در فایل Robot.txt نیز قید شود در بهینه سازی نرخ خزش سایت خود موفق عمل کردهاید.

دسترسی به پوشه های CSS یا JS را مدیریت نمایید

برخی از سئوکاران کم تجربه برای اینکه بتوانند نرخ خزش و همچنین ایندکس صفحات خود را مدیریت کنند، دسترسی خزندههای گوگل به پوشههای CSS و یا JS را محدودیت میکنند. این کار باعث اختلال در رندرگیری از صفحات شما میشود و به لحاظ تکنیکال به سایت آسیب وارد میکند. با در نظر گرفتن این موضوع تا جایی که ممکن است، دسترسی به چنین صفحاتی را محدود نکنید. چرا که عملکرد سایت خود را با مشکل مواجه خواهید کرد.

مسدود کردن صفحات دسته بندی و برچسبها اشتباه است

سئوکاران کلاسیک برای مدیریت نرخ خزش سایت خود دسترسی به صفحات دسته بندی و برچسبها را محدود میکردند و برای آن چندین خط در فایل Robot.txt قرار میدادند. چنین استراتژی درک گوگل از ماهیت و ساختار سایت شما مشکل ایجاد میکند. گاها مشاهده میکنید که در صفحات محصول شما در بخش Shopping Google نمایش داده نمیشود. این موضوع به دلیل درک ناقص گوگل از ساختار دیتای صفحات شما است. اجازه دسترسی خزندههای گوگل به صفحات دسته بندی نه تنها بودجه خزش شما را از بین نمیبرد، بلکه سرعت ایندکس محصولات جدید شما را افزایش میدهد.

سخن پایانی

در این پست آموزشی به صورت کامل و جامع به بررسی پاسخ سوال « فایل Robot.txt چیست » پرداختیم. از طرفی بهترین استراتژی بهینه سازی آن را با یک دیگر مطرح نمودیم. در صورتی که هر بخش از این پست آموزشی برای شما چالش برانگیز و یا گنگ بود، در بخش نظرات با ما مطرح کنید. همکاران ما در کوتاهترین زمان ممکن پاسخ سوال شما را بررسی خواهند کرد و به پاسخ مناسب آن را به شما اطلاع خواهند داد. در پایان لازم است که یک جمع بندی از نکات مطرح شده در این پست آموزشی خدمت شما عزیزان ارائه دهیم. در صورتی که یک سایت دارای فایل Robot.txt نباشد، داخل گوگل و دیگر موتورهای جستجو مانند Bing Or Yandex ایندکس نخواهد شد. با این حال اگر از قالب وردپرسی برای این موضوع استفاده میکنید، شرایط اندکی متفاوت خواهد بود.

ممکن است که گوگل تمامی صفحات شما را ایندکس کند، اما نرخ خزش و سرعت ایندکس شما بسیار پایین خواهد بود. مهم نیست که سایت شما چند صفحه دارد و دامین آتوریتی شما در چه جایگاهی قرار دارد. سایت شما برای شناخته شدن توسط موتورهای جستجو به یک فایل Robot.txt و همچنین نقشه سایت دقیق نیاز دارد. در صورتی که نقشه سایت شما توسط موتورهای جستجو به خوبی شناخته نشود. عملکرد سایت تان با چالش مواجه خواهد شد و در نتیجه ترافیک سایت همواره در کمترین حالت ممکن قرار خواهد گرفت. نکات مطرح شده در برای بهینه سازی فایل Robot.txt جدی بگیرید و بهینه سازی آن را در چک لیست سئو تکنیکال خود قرار دهید.

امیر شادان پور 😎 متخصص تولید محتوا « Content Marketing »و رپورتاژ نویسی پژوهشگر حوزه سئو و علاقه مند به تولید محتوای کاربردی و سئو شده، علاقه مند به حوزه تکنولوژی و دیجیتال مارکتینگ توانایی تولید محتوای تخصصی و ترجمه زبان انگلیسی مشغول همکاری با برترآموز😏

نظرات کاربران